Outils 6 sigma

Nous avons rassemblé dans cette section du Blog de BLUE LEAN CONSULTING quelques billets sur les principes essentiels de l'approche 6 sigma :

Vocabulaire anglais spécifique au 6 sigma

| English | Français |

| 7 points in row | 7 points d'affilée (tendance sur un carte de contrôle) |

| a boxplot (box-and-whisker diagram) | une boîte à moustache |

| a control chart | une carte de contrôle |

| a controllable factor (DOE) | un facteur contrôlé |

| a data collection planning | un plan de collecte des données |

| a design of experiments | un plan d'expériences |

| a dot plot | un diagramme des fréquences |

| a fishbone diagram | un diagramme en arête de poisson |

| a formula | une formule |

| a gate review (DMAIC) | la revue de fin d'étape |

| a lurking variable | une variable cachée |

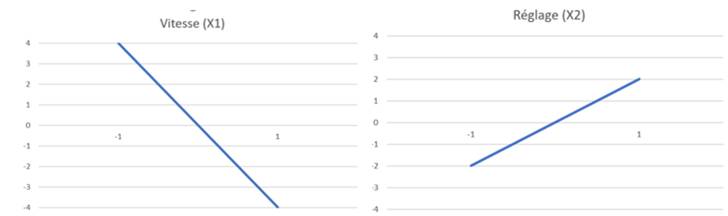

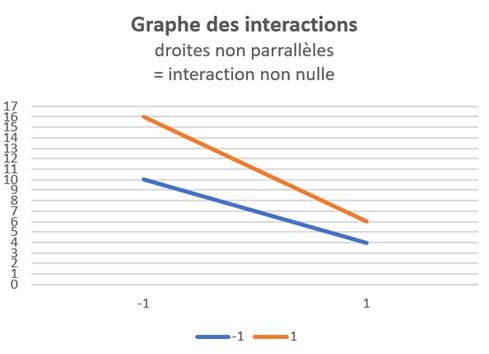

| a main effect plot / interaction plot | un diagramme des effets / des intercations |

| a pairwise comparison (ex : Tukey) | une comparaison (des moyennes) deux à deux |

| a Pareto chart | un diagramme de PARETO |

| a ranked order set of data | des données ordonnées |

| a run (DOE) | un essai |

| a run / trial (DOE) | un essai |

| a sample | un echantillon |

| a scatter plot >> positive/négative/no correlation | un graphe des effets ( (Y = f(X1) - autres Xi fixés) |

| a survey | une enquête |

| a two-way / three-way interaction (DOE) | une interaction du 2ème/3ème ordre |

| an hypothesis testing | un test d'hypothèse |

| an outlier | un point aberrant |

| ANOVA assumptions : normal distribution - equal of variances | les pré-requis de l'ANOVA |

| cause-focused tools : 5 Whys - Fishbone diagram | outils d'analyse des causes : 5P - Ishikawa |

| Chi square | Khi2 |

| common cause /special or assignable cause | causes communes /spéciales |

| defective | défaillant - douteux |

| descriptive statistics | statistiques descriptives |

| df (degree of freedom) | ddl (degrés de liberté) |

| fractional-factorial DOE | plan fractionnaire |

| full DOE | plan complet |

| gage R&R | test R&R |

| in statistical control / out of control | sous contrôle statistique / hors contrôle |

| independent data | données indépendantes |

| inferential statistics | statistiques inférentielles |

| input variable / independent variable (X) | facteur X |

| linearity / accuracy / stability / discrimination | linéarité / précision / stabilité / discrimination |

| MSA (measurement system analysis) | analyse du système de mesure |

| noise factor (DOE) | facteurs bruits |

| normally distributed | distribuées suivant une Gaussienne |

| on one side of the average | d'un côté de la moyenne |

| one-way / two-way ANOVA | ANAVAR à un facteur / deux facteurs |

| output/response variable / dependent variable (Y) | caractéristique Y |

| paired / independent samples | échantillons apprairées / indépendantes |

| Pearson coefficient r (correlation) / r² is the percentage of variation in Y that is attributed to X | Coefficient de Pearson r / r² |

| random | aléatoire |

| regression : simple linear / multiple | régression : linéaire simple / multiple |

| reject / accept the null hypothesis | accepter / rejeter l'hypothèse nulle |

| repeatability & reproductibility | répétabilité & reproductibilité |

| short-term/lon-term capability | capabilité court/long-terme |

| skewed data | données assymétriques |

| steadily increasing / decreasing | en hausse / baisse constante |

| the 95% confidence interval | l'intervalle de confiance à 95% |

| the central limit theorem | le théorème central limite |

| the central tendancy / spread | la position / la dispersion |

| the confidence level = 1 - α | e niveau de confiance = 95% |

| the control limits | les limites de contrôle |

| the control limits (upper UCL / lower LCL) | les limites de contrôle (sup / inf) |

| the data display | la représentation es données |

| the histogram (frequency plot) | l'histogramme |

| the kurtosis | le coefficient d'applatissement |

| the levels of a factor | les modalités d'un facteur (ANOVA) ou niveaux (DOE) |

| the mean / the average | la moyenne |

| the median | la médiane |

| the null/alternative hypothesis | l'hypothèse nulle (H0) / alternative (H1) |

| the range | l'étendue |

| the S/N - signal to noise ratio | le rapport signal sur bruit |

| the sample size | la taille de l'échantillon |

| the sampling | l'échantillonnage |

| the spread | la dispersion |

| the standard deviation | l'écart-type |

| the sum of squares (SS) | la somme des carrés |

| the type of data (attribute or discrete/ continuous data) | le type de donnée (données discrètes / continues) |

| the variance (advantage : additive) | la variance |

| the variation | la variabilité |

| the who/what/where/when/how and why (five W et one H)- Is/Is'nt The last W is asked 5 times (the 5 why) |

QQOQCP / Est-N'est pas 5P (pourquoi) |

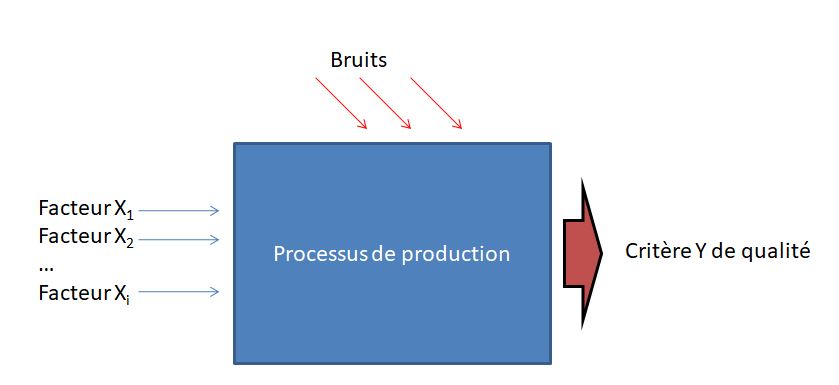

| α risk : probability to conclude there is a difference when there really isn't | risque alpha |

Les plans d'expérience (ou DOE - design of experiments en anglais) sont une méthode d’optimisation de la démarche expérimentale, vulgarisée dans le domaine industriel par le qualiticien japonais Génichi TAGUCHI, à partir des années 1960. Leur mise en œuvre est adaptée à l’optimisation du réglage des paramètres de multiples facteurs X contrôlés ayant une influence sur la qualité d’un produit (c’est le critère Y à minimiser, maximiser ou à cibler) tout en réduisant l’influence des facteurs non contrôlés (le bruit), difficiles ou trop coûteux à contrôler. Plutôt que d’éliminer ces facteurs bruits, il s’agit de trouver la combinaison des facteurs contrôlés rendant le produit « insensible » à ceux-ci.

Dans une démarche 6 sigma, les plans d’expérience sont généralement mis en œuvre dans la phase « Improve » de la méthode DMAIC, c'est-à-dire lorsque l’on vise à déterminer la meilleure relation liant les X aux Y afin d’atteindre la qualité désirée (en réduisant la variabilité associée au processus de production).

Les plans d’expériences interviennent plutôt dans la phase de conception ou d’industrialisation d’un produit alors que la maîtrise statistique des procédés est plus pertinente en phase de production afin de contrôler et piloter la stabilité du processus de production.

Les plans d’expérience permettent de quantifier l’influence des facteurs X et de leurs interactions ainsi que d’identifier la meilleure combinaison de ceux-ci afin d’améliorer ou d’atteindre un niveau de qualité, tout en minimisant le nombre d’expérimentations à réaliser par une suite d’essais rigoureusement organisés.

Cela revient à rechercher les coefficients αi du polynôme suivant modélisant Y en fonction des X :

Y = α0 + α1 facteur X1 + α2 facteur X2 + α3 Interaction (facteur X1, facteur X2) + ….

La représentation graphique de cette fonction s’appelle la surface de réponse que l’on souhaite optimiser.

Une analyse de la variance (ANOVA) permet alors de conclure quant à la significativité de l’effet des facteurs et des interactions (avec un risque de première espèce de 5% d’affirmer que le facteur n’a pas d’influence alors qu’il en a effectivement une).

Pour bâtir un plan d’expérience, on retient pour chaque facteur un nombre fini de niveaux ayant une influence sur la qualité du produit, faisant ainsi l'hypothèse d'une linéarité de la réponse entre les niveaux. L’ensemble des combinaisons de niveaux de tous les facteurs conduirait à réaliser un nombre très élevé d’expériences (en tenant compte de la combinaison des facteurs), à répéter plusieurs fois pour accumuler des résultats statistiques, afin de tester leur influence sur le produit.

La force de la méthode TAGUCHI est :

- de limiter très fortement le nombre d’essais à réaliser en employant un plan factoriel pour lequel chaque niveau de chaque facteur est confronté à tous les niveaux des autres facteurs et dans des proportions égales (le plan est dit orthogonal),

- d’évaluer l’influence des facteurs non contrôlés (le bruit) sur l’effet des facteurs contrôlés.

Exemple : Avec 7 facteurs à 2 niveaux, il y a à 27 soit 128 combinaisons de facteurs alors que la matrice de Tagushi L8 (27) identifie 8 essais à réaliser !

Le plan d’expérience correspond donc aux essais à réaliser par combinaison de niveaux de facteurs : le plan est dit « complet » lorsqu’il intègre toutes les combinaisons de facteurs (dont les interactions entre facteurs) et « fractionnaire » lorsqu’il est restreint aux seuls facteurs sans tenir compte des interactions.

Chaque essai est répété plusieurs fois afin d’identifier la dispersion (bruit) autour du résultat de l’essai par rapport au critère mesuré, conséquence de l’influence des facteurs non contrôlés. On détermine alors pour chaque essai i, la moyenne Yi des effets et le rapport signal/bruit en dB (en fonction de la moyenne arithmétique des mesures et de leur dispersion) selon les formules développées par TAGUCHI.

Cas d’un critère à minimiser

S/Ni = - 10 * Log ([Σ yi2]/k) = -10 Log (σ²+Y²)

avec Y et σ, moyenne et écart-type des k répétitions de l’essai i

Cas d’un critère à maximiser

S/Ni = - 10 * Log ([Σ 1/yi2]/k) = -10 * Log ((1 + 3 σ²/Y2)/Y2)

avec Y et σ, moyenne et écart-type des k répétitions de l’essai i

Cas d’un critère à la valeur nominale (écart-type proportionnel à la position)

S/Ni = 10 log (Y2/σ²)

avec Y et σ, moyenne et écart-type des k répétitions de l’essai i

Cas d’un critère à la valeur nominale (écart-type indépendant de la position)

S/Ni = -10 log (σ² + (Y – Cible)2)

avec Y et σ, moyenne et écart-type des k répétitions de l’essai i

En faisant l’hypothèse que les effets moyens s’additionnent, on détermine ensuite la meilleure combinaison des facteurs comme étant celle pour laquelle leur effet va dans le sens de l’optimisation recherchée tout en maximisant le ratio signal/bruit.

Une fois les paramètres déterminés, on réalise un essai de validation des résultats obtenus. Afin de tester l'hypothèse de linéarité du modèle, on réalise cet essai de validation au centre du domaine d'étude (pour chaque facteur, on choisit le point médian entre les valeurs min et max). Si cet esssai est concluant (Y doit prendre la valeur moyenne de tous les essais, appelée T ci-dessous), on a alors trouvé la combinaison de facteur X répondant à l'objectif de qualité Y. Il ne reste plus qu'à l l'industrialiser.

Nombre minimal d'essais à réaliser

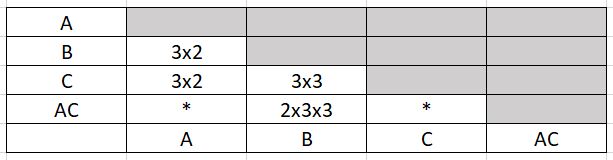

Le nombre minimal d'essais à réaliser pour étudier un système donné (plusieurs facteurs et interactions à des niveaux différents pour chaque facteur) est égal au nombre de degrés de libertés du système. Par exemple, pour l'étude du système suivant :

Y = α0 + α1 A (2 niveaux) + α2 B (3 niveaux) + α3 C (3 niveaux) + α4 AC

ddl =1 + 1 + 2 + 2 + 1 x 2 = 8

Il faudra effectuer au minimum 8 essais pour déterminer les coefficients αi.

La condition d'orthogonalité peut, cependant, conduire à un nombre d'essais supérieur au nombre de degrés de liberté. Cette condition d'orthogonalité indique en effet que le plan devra comporter un nombre d'essais multiple du PPCM du produit du nombre de niveaux de toutes les actions disjointes.

Dans cet exemple, le nombre minimal d'essais à réaliser pour respecter la condition d'orthogonalité est 2x3x3 soit 18 essais.

On comprend donc que pour minimiser le nombre d'essais il faut éviter de prendre des nombres de niveaux premiers entre eux et n'étudier des interactions disjointes que lorsque cela est indispensable.

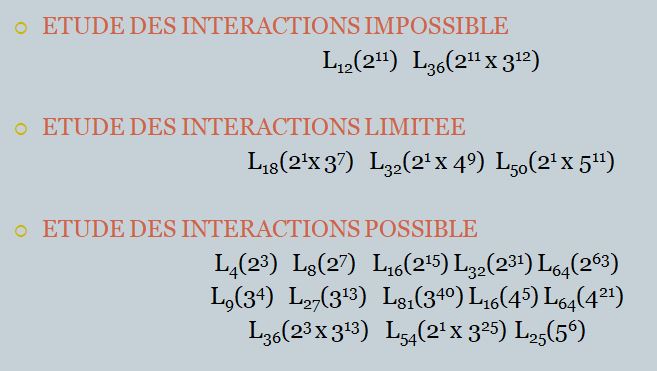

Les tables de TAGUCHI

Elles se présentent sous forme de matrices Ln(Nk) présentant la configuration des essais à réaliser : en ligne les n essais à réaliser, en colonne les k facteurs ou combinaisons de facteurs avec en intersection les niveaux 1 à N à prendre en compte.

Pour un plan complet à f facteurs à 2 niveaux, la table à utiliser est la table Ln(2k) telle que n = 2f . Cette même table peut être utilisée comme plan fractionnaire pour étudier k facteurs sans interaction : chaque colonne est alors affectée à 1 facteur, étant entendu que certains facteurs sont confondus avec certaines interactions entre facteurs, considérées alors comme négligeables.

Les tables de TAGUCHI sont des plans fractionnaires astucieux qui prennent pour hypothèse que les interactions d'ordre 3 (1 facteur x 1 intéraction d'ordre entre 2 facteurs ou 1 intéraction à 3 facteurs) sont négligeables et que seules quelques interactions d'ordre 2 sont non nulles.

Elles sont accompagnées :

- d'un triangle des interactions, indiquant les numéros de colonne correspondant aux interactions entre 2 facteurs, et,

- d'un ou plusieurs graphes des effets, permettant de visualiser les différentes possibilités de mise en oeuvre de la matrice en fonction des interactions à étudier. Ces graphes indiquent également quelles colonnes doivent être affectées aux facteurs les plus difficiles à modifier au cours des expérimentations.

Les 18 tables orthogonales de TAGUCHI, classées en fonction de la possibilité ou non d’étudier des interactions, sont répertoriées ici :

Détaillons, par exemple, la table L4(23).

| N° essai / N° de colonne | 1 | 2 | 3 |

| 1 | 1 | 1 | 1 |

| 2 | 1 | 2 | 2 |

| 3 | 2 | 1 | 2 |

| 4 | 2 | 2 | 1 |

(en intersection de chaque ligne/colonne, on note le niveau 1 ou 2 à adopter pour chaque facteur dans le cadre de l'essai considéré)

-accompagnée du triangle des interactions :

| 2 | 3 | |

| (1) | 3 | 2 |

| (2) | 1 |

-et du graphe des effets :

![]()

Cette table est utilisée :

- Soit pour un plan complet à 2 facteurs A et B (facteur A en colonne 1, facteur B en colonne 2 et intéraction A/B en colonne 3)

- Soit pour un plan fractionnaire à 3 facteurs A,B,C sans tenir compte d’interactions ou plus exactement avec l’éventuelle interaction AB cumulée avec l’effet du facteur C (en colonne 3). On dit que les deux actions sont des alias. La résolution du plan fractionnaire est d’ordre III (1 facteur au moins confondu avec une interaction d’ordre II)

Si cette interaction ne peut pas être négligée, il faudra étudier séparément cette interaction et le facteur C ; pour ce faire, il faudra utiliser un plan complet à 3 facteurs L8 : on dit que l’on « désaliasse » le plan fractionnaire. L’utilisation d’un plan fractionnaire peut conduire à de lourdes erreurs si on néglige des interactions significatives.

On cherche à optimiser la surface de réponse du polynôme suivant :

Y = α0 + α1 A + α2 B + α3 A x B (2 facteurs + 1 interaction)

Ou

Y = α0 + α1 A + α2 B + α3 C (3 facteurs – interactions nulles)

Afin de pouvoir comparer les αi, , on utilise une unité standard, appelée notation de Yates, pour tous les facteurs de -1 (niveau mini) à +1 (niveau maxi).

Les résultats des 4 essais, prescrits par la table et répétés n fois, sont consignés dans le tableau suivant :

(exemple: 2 facteurs A et B + 1 interaction A/B - critère Y à minimiser) :

| Moyenne |

S/N = - 10 * Log (1/n * Σ Yk2) |

||

| Essai 1 | Y11 | S/N(Y11) | |

| Essai 2 | Y12 | S/N(Y12) | |

| Essai 3 | Y21 | S/N(Y21) | |

| Essai 4 | Y22 | S/N(Y22) |

On note :

- Xi la moyenne des résultats lorsque le facteur X est de niveau i, et,

- T la moyenne des résultats de tous les essais de la matrice de Tagushi (moyenne du plan) = (Y11 + Y12 +Y21+Y22) / 4

On montre que :

- Effet (Xi) = Xi – T → par exemple : Effet (A1) = (Y11+Y12)/2 - T.

On note que ∑ Effet (Xi) = 0. On dit que le facteur Xi a (N-1) degrés de libertés, c'est à dire qu'il suffit de calculer (N-1) effets pour connaître tous les effets du facteur X.

- Effet (Interaction XiYj) = XiYj– Effet (Xi) – Effet (Yj) – T → par exemple : Effet (A1;B2) = Y12 - Effet(A1) - Effet(A2) - T

On note que ∑ Effet (XiYj) à i fixé = 0. L'intéraction XiYj comporte (N-1) x (N'-1) degrés de libertés.

alors : α0 = T ; αi = Effet (X2 ou Interaction X2Y2)

Les effets doivent être calculés sur les valeurs brutes Y et sur les valeurs signal/bruit S/N(Y) car les facteurs peuvent avoir une influence ou non sur les unes et/ou les autres. Le calcul des αi permet d'établir les graphes des facteurs et les graphes des interactions, représentant la dépendance supposée linéaire de chaque effet/facteur sur la plage normalisée [-1;1].

La significativité des effets peut être établie grâce à une analyse de la variance ou ANOVA (effet significatif si F > Flimite):

|

|

A |

B |

AxB |

Résidus |

TOTAL |

|

SS |

nx4xEffet(A1)² |

nx4xEffet(B1)² |

nx4xEffet(A1xB1)² |

Total-SSA-SSB-SSAxB |

∑(nx4)(Yk-T)² |

|

ddl |

1 |

1 |

1 |

nx4-1-3 |

nx4-1 |

|

V |

SSA/ddl |

SSB/ddl |

SSAxB/ddl |

Rv=SSR/ddl |

SST/ddl |

|

F |

VA/Rv |

VB/Rv |

VAxB/Rv |

|

|

|

Contribution |

SSA/SST |

SSB/SST |

SSC/SST |

|

|

|

Flimite à 5% |

Table Fisher-Snedecor (1 ; nx4-1-3) |

|

|

||

On détermine alors la meilleure combinaison des facteurs A (-1 ou +1) et B (-1 ou +1) comme étant celle pour laquelle leur effet va dans le sens de minimiser l'équation Y = α0 + α1 A + α2 B + α3

Le concept de capabilités en 6-sigma

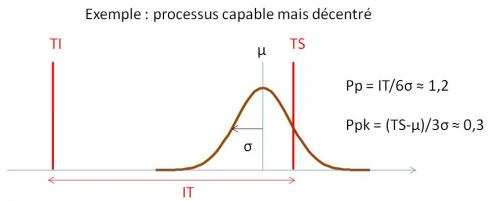

La capabilité sert à quantifier l’aptitude d’un processus (compte tenu de ses limites naturelles) à produire à l’intérieur d’un intervalle de tolérance. L’étude des capabilités consiste à analyser l’adéquation des performances du moyen de production et son évolution dans le temps, par rapport à l’objectif de performance visé (valeur cible et intervalle de tolérance).

On distingue:

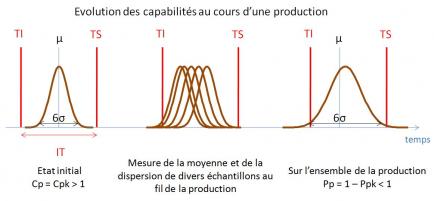

· La capabilité court-terme du processus, Cp, qui compare la dispersion naturelle du processus (sans action de causes spéciales) et l’intervalle de tolérance (IT): Cp = IT / 6σCT. C’est donc la capabilité du moyen de production si l’on arrive à stabiliser le moyen, c'est-à-dire à éliminer les causes spéciales occasionnant un étalement de sa dispersion.

· La performance long-terme du processus, Pp, qui prend en compte sur l’ensemble de population l’action des causes spéciales (occasionnant une dérive de la position moyenne du processus): Pp = IT / 6σLT. Elle traduit la qualité des produits livrés au client.

Cp et Pp vérifient: Pp ≤ Cp

On définit également un indicateur de déréglage long-terme, Ppk, ratio de la distance entre la moyenne sur toute la population (μ) et la limite de tolérance la plus proche (TS ou TI), divisée par 3 σLT: Pp = (μ-T)/3σLT.

Un processus est dit capable sur le long terme, c'est-à-dire susceptible de ne pas produire de pièces défectueuses, si Ppk > 1,33 (i.e., moins de 64 pièces défectueuses par million pour un processus centré tel que Ppk=Pp=1,33).

Ainsi, un processus part d’un potentiel de capabilité égal à Cp. La chute de capabilité de Cp à Pp traduit l’instabilité du processus (c'est-à-dire l’étalement de sa dispersion avec le temps parce que la machine ne tient pas la consigne sur la valeur cible et que ces écarts ne sont pas corrigés) alors que la chute de capabilité de Pp à Ppk est due au déréglage du processus sur le long terme (écart de la moyenne par rapport à la cible).

L’étude de cette « chute des capabilités » est un outil puissant de l’approche 6-sigma pour améliorer très sensiblement le taux de qualité d’un processus de production.

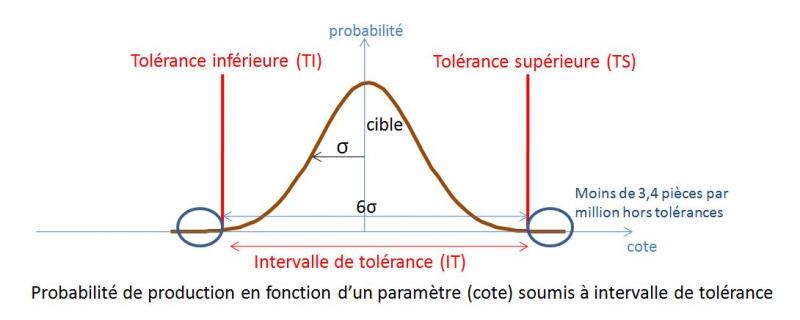

La méthode 6-sigma, développée par Motorola puis généralisée par General Electric dans les années 1990, est une méthode d'amélioration continue des processus de fabrication visant à réduire les variabilités à l'origine des non-qualités. Elle a donc la même finalité que le pilier JIDOKA de l'approche Lean mais s'appuie plus particulièrement sur l'analyse des données:

· recueillies auprès du client et

· mesurées en production afin de déterminer les paramètres à l'origine des variabilités, que l'on souhaite piloter dans un mode "prédicitf".

L'approche 6-sigma englobe à la fois un objectif qualité et une démarche de résolution de problème, structurée en « projet ». C’est une approche qui va au-delà des outils standards MRP du Lean (QQOQCP, 5P, SQDC, Brainstorming) qui visent à « faire parler les hommes ». Il s’agit ici de « faire parler les processus » afin de découvrir la fonction de transfert qui relie les paramètres de sortie du processus (Y) aux paramètres d’entrée influents (X).

Pour reprendre une formulation empruntée à Maurice Pillet, les valeurs fondamentales du 6-sigma sont :

· La maîtrise de la variabilité (écart entre une situation attendue et une situation réelle),

· La culture de la mesure,

· La recherche des caractéristiques critiques pour le client (CTQ),

· La notion de preuve statistique, et,

· Le respect de la méthode DMAIC.

Les outils principaux de la méthode 6-sigma sont:

· la méthodologie DMAIC,

· la maîtrise statistique des procédés et les cartes de contrôle,

· les plans d'expérience,

· les différents tests que nous offrent les statistiques inférentielles.

La conjugaison des approches Lean et 6 sigma, appelée Lean 6-sigma (LSS), permet d'associer l'efficacité du juste-à-temps et la puissance de la maîtrise de la variabilité.

L'appellation « 6 sigma » fait référence à l'écart-type (σ) d'une distribution supposée gaussienne[1] de la variabilité de tout processus. La méthode 6-sigma vise donc à maîtriser le processus de production tel que seules les pièces au delà de +/-6σ autour de la moyenne (compte tenu d'un décentrage maximum de 1,5 σ) soient rebutées, ce qui revient à rejeter moins de 3,4 pièces par million de pièces produites. Si cet objectif est à la portée de certaines industries, une grande majorité vise 4 voire 3 sigma.

[1] Postulat de la maîtrise statistique des procédés (découlant du théorème central limite) : en l’absence de déréglage et compte tenu des différents facteurs indépendants et d’un ordre de grandeur équivalent, la répartition de la production d’une machine en fonction d’une caractéristique donnée suit une loi normale de moyenne μ et d’écart-type σ.

La maîtrise statistique des procédés et les cartes de contrôle

La maîtrise statistique des processus (MSP ou SPC - statistical process control) est l'un des principaux outils de la démarche 6-sigma. Elle s'intègre également dans le pilier JIDOKA (bon du premier coup) de l'approche Lean dans la mesure où elle permet de réduire la variabilité du processus de production.

L'objet de la MSP est de donner aux opérateurs de machines de production un outil graphique simple de pilotage de la production (il s’agit d’autocontrôle) leur permettant de maintenir la production centrée sur sa cible et de maintenir sa dispersion à l'intérieur de l'intervalle de tolérance spécifié (IT).

La MSP s'appuie sur deux outils fondamentaux:

· le suivi des processus par « cartes de contrôle » (créées par W. Shewhart, dès 1930) et

· la mesure des capabilités des moyens de production (développée à partir des années 1970).

Adaptée aux productions en série, la MSP reste pertinente également pour les productions en très petites séries voire unitaires (l'effet de série pourra être rétabli en calculant une moyenne glissante des valeurs individuelles).

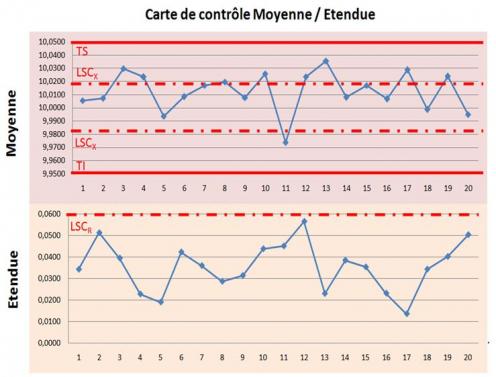

Les cartes de contrôle

Les cartes de contrôles permettent de piloter la production (régler les consignes appliquées aux machines) par rapport aux limites naturelles du processus (il s’agit de la dispersion du moyen de production autour de sa consigne en l’absence de cause particulière de déréglage) et non par rapport aux spécifications (intervalle de tolérance défini par la tolérance supérieure, TS et la tolérance inférieur, TI), qui servent seulement à accepter ou non une production.

Un pilotage aux tolérances consistant à régler une machine uniquement lorsque la cote d’une pièce sort de l’intervalle de tolérance conduit, en effet, à appliquer des réglages trop tardivement (des rebuts ont déjà été produits) ou à tort (alors que la machine est en fait centrée).

Ainsi, même pour une production soumise à un tri à 100%, les cartes de contrôle restent pertinentes: le tri permet d'écarter les pièces non conformes alors que les cartes de contrôle permettent d'éviter de produire des pièces non conformes !

Le suivi de production par cartes de contrôle consiste à prélever, à fréquence constante, un échantillon de pièces dont on mesure la caractéristique qui fait l’objet du suivi (généralement une cote): l’opérateur calcule alors la moyenne et l’étendue de chaque échantillon qu’il reporte sur une carte afin de les comparer aux limites naturelles du processus. Lorsque ces valeurs « sortent » des limites, l’opérateur sait que le processus fait l’objet d’une cause spéciale (un déréglage, un défaut de lubrification, un outil usé,...). Il doit, alors, prendre l’action corrective qui va permettre de recentrer le processus sur sa cible, à l’intérieur de l’intervalle de tolérance.

La démarche DMAIC est une méthodologie ordonnée et rigoureuse utilisée en amélioration des performances et plus particulièrement en approche 6-sigma, en percée Kaizen ou pour toute résolution de problème. Elle se compose de 5 étapes dont les initiales forment l'acronyme DMAIC.

Chaque étape est formellement clôturée par une revue d’étape présidée par le « Champion » ou « Sponsor » du projet

· DEFINE: Il s'agit de définir le périmètre du sujet que l'on souhaite traiter et de cibler l'objectif à atteindre, en cohérence avec la demande client. Cette phase permet également de produire une charte de projet (au format A3) avec un planning réaliste ainsi qu'un plan de communication du projet. Afin de mieux cibler le besoin client, des outils tels que le SIPOC (supplier input process output client) ou les CTQ (recherche des caracétristiques "critical to quality") seront mis en oeuvre. Une première identification des causes possibles de non satisfaction client et/ou d’occurrence de la variabilité pourra être recherchée grâce aux méthodes de résolution de problème QQOQCP (Qui ? Quoi ? Où ? Quand ? Comment ? Pourquoi ?) et diagramme d'Ishikawa.

· MEASURE: L'objectif est de collecter des données sur le terrain, représentatives de la situation actuelle, afin de mieux appréhender les causes racines du problème (statistiques descriptives - diagramme dePareto). ll s'agit également de vérifier que le processus de mesure est acceptable vis à vis des objectifs recherchés en comparant la variance du processus de mesure à la variance du processus à mesurer (Gage R&R). En fin d'étape on pourra estimer le z du processus et sa capabilité (Cp, Pp, Ppk) (voir la notion de capabilités).

· ANALYSE: Il s'agit d'identifier et d'établir l'influence des paramètres qui causent les variabilités du processus par l'exploitation des données collectées dans la phase précédente. Les causes racines pourront être mises en évidence grâce aux outils de résolution de problèmes (brainstorming – diagramme d’Ishikawa – méthode des 5 pourquoi). En approche 6-sigma, cette phase repose sur des outils statistiques permettant de démontrer les relations qui lient les données d'entrées X aux paramètres de sortie Y (diagramme des effets, tests de normalité, tests des moyennes , tests des variances, ...).

· IMPROVE (améliorer): Sur la base des résultats de l'analyse menée précédemment, il s'agit d'établir les solutions qui doivent permettre de mettre sous contrôle le processus afin de réduire les variabilités, c’est-à-dire passer en mode « prédictif ». Lorsque plusieurs solutions sont imaginées, elles pourront être hiérarchisées, pour leur mise en œuvre, grâce à une matrice enjeux/accessibilité. La meilleure combinaison des données d'entrée X pour optimiser les paramètres de sortie Y pourra être déterminée grâce aux plans d'expérience.

· CONTROL (maîtriser): Cette dernière phase vise à pérenniser la solution définie dans la phase précédente en mettant en place des indicateurs de suivi ou de supervision de la maîtrise du processus. On retrouve ici l'un des principes du Lean qui établit que tout progrès doit être « calé » par la mise en place d'un standard. C'es au cours de cette phase que l'on déploiera de manière privilégiée les cartes de contrôle.

La démarche DMAIC s'inscrit pleinement dans la logique du cycle de Shewhart ou PDCA (appelée également « roue de Deming ») avec les correspondances suivantes:

- Plan = Define + Mesure + Analyse

- Do = Improve

- Check + Act = Control

La méthode DMAIC est également cohérente de la méthode de résolution de problèmes 8D (pour 8 DO), largement utilisée dans l'industrie automobile, qui distingue les actions correctives immédiates des actions correctives définitives et permanentes. On peut établir les correspondances suivantes entre les 2 méthodes :

- Define = Constituer l'équipe (1D) - Définir le problème (2D)

- Mesure + Analyse = Prendre les actions immédiates (3D) - Déterminer les causes du problèmes (4D)

- Improve = Déterminer les actions définitives et permanentes (5D) - Mettre en oeuvre les solutions (6D)

- Control = Eviter la récurrence et la réapparition du problème ailleurs (7D) - Féliciter l'équipe (8D)